26.03.2024 | Blog Generative KI: Vom Hype zur praktischen Anwendung in Unternehmen

ChatGPT-Erfahrung im Unternehmensumfeld

Viele Organisationen haben bereits erste Schritte unternommen und allgemein zugängliche generative Anwendungen wie ChatGPT getestet. Von der Recherche über das Erstellen von Gliederungen und Präsentationen bis hin zur Ideensammlung für Marketingtexte. Nun gilt es, über den Experimentiermodus einzelner Abteilungen hinauszugehen und neben der Nutzung allgemein zugänglicher Informationen konkrete Anwendungen mit organisationseigenen Daten zu implementieren, die Prozesse beschleunigen und die Effizienz erhöhen, beispielsweise

- im Kundenservice und Helpdesk

- im Vertrieb

- im Wissensmanagement

- in der Sachbearbeitung

- im Bürgerservice

Herausforderungen bei der Integration von Unternehmenswissen

Wie Studien zeigen, wollen Unternehmen generative KI einsetzen. Ein besonderer Aspekt, den Organisationen berücksichtigen müssen, um von generativer KI profitieren zu können, ist die effektive und sichere Nutzung ihrer eigenen Daten mit Large Language Modellen. LLMs wurden mit immensen Mengen an allgemeinem Wissen trainiert, aber wie kann sichergestellt werden, dass das LLM auch organisationsspezifische Informationen oder Branchen Know-how einbezieht? Nur damit ist es möglich, den Kundenservice zu optimieren oder in der öffentlichen Verwaltung Aktenvermerke teilautomatisiert zu erstellen. Die Verlässlichkeit und Richtigkeit des Outputs steht dabei ebenso im Vordergrund wie die Gewährleistung von Datensicherheit und Zugriffsrechten.

Die Herausforderungen sind:

- Spezifisches Wissen einbeziehen

Unternehmen müssen sicherstellen, dass die generative KI auf ihr eigenes Wissen zugreifen kann. Will man Mitarbeiter beispielsweise im Kundenservice unterstützen, müssen Artikelnummern, Produktbezeichnungen, Fehler- und Lösungsbeschreibungen auffindbar sein. - Valide, aktuelle Antworten und Zusammenfassungen erhalten

Der KI-generierte Inhalt muss den organisationsspezifischen Anforderungen entsprechen und qualitativ hochwertigen - und vor allen Dingen korrekten - Output liefern. Eine zielgerichtete Retrieval-Lösung ist gefragt, die auch aktuelle interne Daten miteinbezieht, um verlässliche Inhalte zu identifizieren und diese dann an ein generatives LLM weiterzugeben. Denn ein LLM kennt nur die Daten bis zum Zeitpunkt seines Trainings. - Datensicherheit und Zugriffsrechte gewährleisten

Bei der Nutzung von LLMs sollten sich Organisationen Gedanken über den Schutz ihrer Daten machen. Zum einen dürfen Unternehmenswissen und eigene Daten nicht abfließen, damit KI-Hersteller ggf. künftige Generationen von Large Language-Modellen damit optimieren. Zum anderen muss selbstverständlich über die Berechtigungsstrukturen der Datenquellsysteme dafür gesorgt sein, dass auch innerhalb der Organisation nur berechtigte Personen auf entsprechende Informationen zugreifen können. Auch sogenannte „Prompt Injections“ mit denen ein generatives LLM in seiner Funktionalität manipuliert werden kann, müssen verhindert werden.

Die Lösung: Retrieval Augmented Generation (RAG) kombiniert LLMs mit Enterprise Search

Wie löst man die Herausforderung, unternehmenseigene Daten sicher für generative KI zu nutzen? Die Antwort liegt in intelligenter Enterprise Search-Software. Diese Software für organisationsweite Informationssuche bindet zunächst die gewünschten Unternehmensquellen an und bündelt sie in einem Suchindex. Dabei setzt die Software ausgeklügelte Verfahren der KI, des Machine Learning, des Natural Language Processing und der semantischen Vektorsuche ein, um beste Suchergebnisse zu liefern. Aus den so gefunden rechtegeprüften Informationen erstellt generative KI hilfreiche Antworten oder Zusammenfassungen inklusive Quellenangaben. Da das Sprachmodell somit valide organisationseigene und domänenspezifische Informationen und Daten erhält, schwindet die Gefahr einer Halluzination deutlich. Dieses Konzept nennt man in der Fachsprache RAG – Retrieval Augmented Generation.

| 2. Generative KI ermöglicht aus den so gefunden Informationen z.B. |

|

|

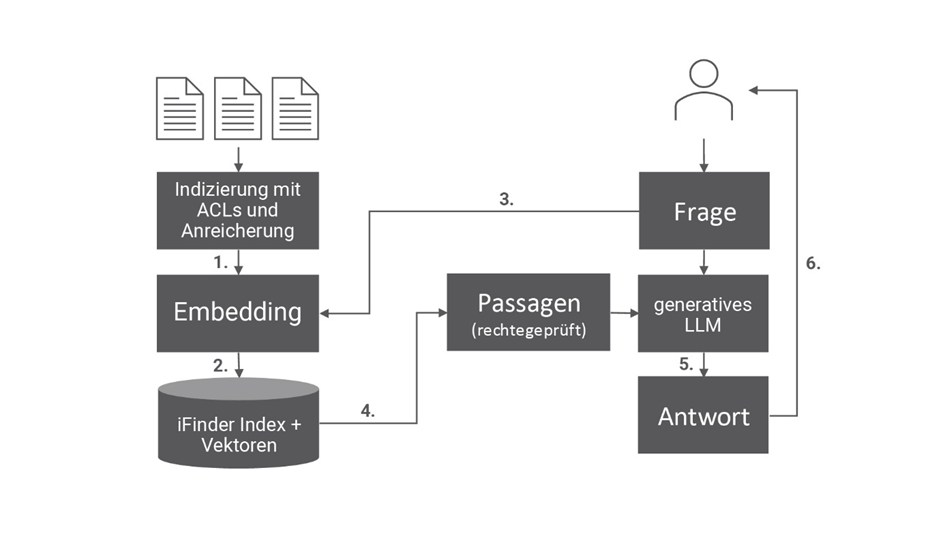

Wie funktioniert das technisch?

Retrieval Augmented Generation schaltet Suchsoftware zwischen Frage und die KI-generierte Antwort

Mit Hilfe von Retrieval Augmented Generation werden große KI-Sprachmodelle mit Enterprise Search-Technologie kombiniert.

Enterprise Search bindet über Konnektoren alle gewünschten Datenquellen an, indiziert deren Daten und Dokumente und reichert diese während des Indizierungsprozesses an. Damit wird ein linguistisch normalisierter Volltextindex aufgebaut. Neben diesem Prozess werden die Dokumente in einer internen Verarbeitung in Passagen aufgeteilt und numerische Darstellungen des Textes mit sogenannten Embedding-LLMs generiert. In diesem Verfahren werden Vektoren (Embeddings) erzeugt, die den Inhalt eines Textes mit einer Vielzahl von numerischen Werten repräsentieren. Diese Methode ermöglicht es der Software, Dokumente oder Passagen zu identifizieren, die inhaltlich eng mit einer Suchanfrage verbunden sind.

Kommen in den angeschlossenen Datenquellen neue Dokumente oder Daten hinzu, werden sie von der Suchsoftware automatisch indiziert. Dadurch ist ihr Index immer auf dem aktuellen Stand. Zudem bringt eine geeignete Software ein durchgängiges Rechte- und Rollenmanagement mit. Sie berücksichtigt Zugriffsrechte bereits bei der Indexierung und übernimmt sie automatisch bei der Suche und der Ausgabe der Treffer. Auf diese Weise werden den Anwendern in ihren Suchergebnissen nur die Daten angezeigt, für die sie eine entsprechende Berechtigung besitzen.

Weitere Sicherheitsfaktoren beim Einsatz von LLMs

Nicht nur LLM-basierte Chatbots im Internet bzw. auf Webseiten, sondern auch LLM-basierte Systeme im Unternehmen müssen vor Missbrauch durch sogenannte Prompt Injections geschützt werden: Dies geschieht durch eine Reihe von Schutzmechanismen, die manipulative oder schädliche Eingaben (Prompts) filtern und die Erzeugung von unangemessenen oder unerwünschten Antworten unterbinden.

Zudem ist wichtig zu betonen, dass Enterprise Search-Produkte wie der iFinder von IntraFind LLMs für die Erzeugung von Embeddings und für generative KI On-premises ermöglichen, also auf organisationseigenen Servern genutzt werden. So fließen keine Informationen an Cloud-Dienste ab – mögen sie noch so fleißig behaupten, dies wäre sicher.

Für den generativen Part ist hier der Einsatz von GPU-Rechenleistung On-premises erforderlich. Dies bietet IntraFind aber auch als exklusiven Service (LLM as a Service) für iFinder-Kunden an, die zunächst ohne eigene GPUs die Möglichkeiten generativer KI erproben möchten.

Wie wählt man das passende Large Language Model aus?

Neben den bekannten LLMs großer Tech-Konzerne wie GPT oder LaMDA /Gemini gibt es sehr gute andere proprietäre Modelle wie beispielsweise Luminous des deutschen Hersteller Aleph Alpha. Zudem liefern Open Source Modelle hervorragende Ergebnisse. Je nach Anwendungsfall bringen auch oft kleinere, spezialisierte KI-Modelle die gewünschten Resultate. Neben der Modellgröße sollte man auch die Größe des sogenannten Kontextfensters des LLM beachten, also die Textmenge, die das Modell auf einmal sichten bzw. analysieren kann.

Bei proprietären LLMs ist eine Betrachtung der anfallenden Kosten geboten, in dem man die oft schwer vorhersagbaren Token-basierten Preismodelle sorgfältig bewerten sollte. Nach dem Vendor-Lockin bei einem der Plattformanbieter ist eine Ernüchterung über ausufernde monatliche Nutzungskosten im schwer kalkulierbaren Preismodell fast zwangsläufig.

Last but not least: Denken Sie auch an Usability. Es gibt Modelle, die wie ChatGPT die Antwort fließend generieren oder auch nach etlichen Sekunden Wartezeit die Komplettantwort auf einen Schlag einblenden.

Wenn Unternehmen den Einsatz generativer KI im Zusammenspiel mit einer Enterprise Search-Software wie dem iFinder von IntraFind einsetzen, müssen sie sich keine Gedanken über die Auswahl des KI-Modells machen. Das übernehmen wir als Anbieter, abgestimmt auf Ihren Use Case. Sollten Sie schon weiter sein und ein eigenes LLM mitbringen, können wir auch dieses in die Suche einbeziehen.

Fazit: Valide Antworten statt Halluzinationen à la ChatGPT sind möglich

Trotz der vielversprechenden Vorteile, die der Einsatz generativer KI mit sich bringt, gibt es Herausforderungen in Bezug auf organisationsspezifische Informationen und Datensicherheit. Wir bei IntraFind unterstützen Sie dabei, zuverlässigen Output und ein wasserdichtes Zugriffs-Management zu gewährleisten. Kommen Sie mit Ihrer Anwendungs-Idee auf uns zu. Wir unterstützen Sie, diese weiterzuentwickeln und umzusetzen.

Weiterführende Seiten und Artikel

Retrieval Augmented Generation – was hat es damit auf sich?

Mehr zu generativer KI und iFinder Enterprise Search

Der Autor

Franz Kögl